Computação Científica: O poder do hardware de alta performance na pesquisa e inovação

24/11/2025

A computação científica transformou radicalmente a forma como pesquisadores, cientistas e engenheiros enfrentam problemas complexos. Desde simulações climáticas que preveem mudanças ambientais até modelos moleculares que aceleram o desenvolvimento de novos medicamentos, essa disciplina tornou-se indispensável para o avanço científico e tecnológico contemporâneo.

Mas afinal, o que torna a computação científica tão especial? E por que ela exige hardware muito além do convencional? Neste artigo, vamos explorar os fundamentos dessa área, suas aplicações práticas e a importância crítica de contar com workstations de alta performance.

O que é Computação Científica?

Computação científica é a área que utiliza métodos computacionais avançados, algoritmos matemáticos e poder de processamento intensivo para resolver problemas científicos e de engenharia que seriam impossíveis ou impraticáveis de solucionar analiticamente. Ela representa a interseção entre ciência da computação, matemática aplicada e domínios específicos do conhecimento.

Diferentemente da computação tradicional, que muitas vezes lida com tarefas de uso geral, a computação científica concentra-se em:

- Simulações numéricas complexas: Reprodução digital de fenômenos físicos, químicos ou biológicos

- Análise massiva de dados: Processamento de terabytes ou petabytes de informações experimentais

- Modelagem matemática: Resolução de equações diferenciais, otimizações e problemas estatísticos

Visualização científica: Representação gráfica de dados multidimensionais

Como funciona a Computação Científica?

O processo de computação científica geralmente segue um fluxo estruturado que combina teoria, modelagem e processamento computacional:

1. Formulação matemática

O primeiro passo envolve traduzir um problema real em um modelo matemático. Por exemplo, simular o fluxo de ar ao redor de uma asa de avião requer equações de dinâmica dos fluidos (Navier-Stokes), que descrevem como velocidade, pressão e densidade variam no espaço e no tempo.

2. Discretização e algoritmos numéricos

Como computadores trabalham com números finitos, é necessário discretizar problemas contínuos. Métodos como elementos finitos, diferenças finitas e volumes finitos dividem o domínio do problema em pequenas partes calculáveis. Sendo assim, algoritmos numéricos específicos são então aplicados para resolver as equações resultantes.

3. Implementação computacional

Os algoritmos são codificados em linguagens de programação otimizadas para computação científica, como Python (com NumPy/SciPy), C++, Fortran, Julia ou MATLAB. A implementação deve ser eficiente, aproveitando paralelização e recursos de hardware especializados.

4. Processamento de alta performance

Aqui entra o papel crucial do hardware. Problemas científicos frequentemente envolvem:

- Operações matriciais massivas: Multiplicações e decomposições de matrizes com milhões de elementos

- Cálculos de ponto flutuante intensivos: Bilhões de operações matemáticas por segundo

- Processamento paralelo: Distribuição de tarefas entre múltiplos núcleos e processadores

5. Análise e validação

Os resultados são comparados com dados experimentais, soluções analíticas conhecidas ou outros modelos para garantir precisão e confiabilidade.

Principais aplicações da Computação Científica

Simulações físicas e engenharia

A indústria aeroespacial utiliza dinâmica computacional de fluidos (CFD) para otimizar o design de aeronaves, reduzindo a necessidade de testes em túneis de vento que custam milhões. Empresas como Boeing e Airbus executam simulações que podem levar dias de processamento contínuo, analisando milhões de pontos de dados para prever turbulência, arrasto e eficiência de combustível.

Na engenharia civil, simulações de elementos finitos preveem como edifícios e pontes se comportarão sob diferentes cargas, ventos e até terremotos, salvando vidas através de projetos mais seguros.

Modelagem climática e previsão do tempo

Centros meteorológicos globais rodam modelos climáticos que dividem a atmosfera terrestre em cubos tridimensionais de 10-50 km de lado. Cada cubo contém equações que descrevem temperatura, pressão, umidade e velocidade do vento. Com milhões de cubos sendo calculados simultaneamente, previsões de 7 dias exigem horas de processamento em supercomputadores.

Modelos de mudanças climáticas de longo prazo são ainda mais exigentes, simulando décadas ou séculos de evolução atmosférica para entender impactos futuros do aquecimento global.

Pesquisa em química e descoberta de fármacos

Simulações de dinâmica molecular permitem que químicos “vejam” como moléculas se movem e interagem em escalas de tempo de nanossegundos a microssegundos. Na descoberta de medicamentos, pesquisadores podem testar virtualmente milhões de compostos contra proteínas-alvo, identificando candidatos promissores antes de sínteses caras em laboratório.

Durante a pandemia de COVID-19, a computação científica foi fundamental para modelar a estrutura da proteína spike do vírus e acelerar o desenvolvimento de vacinas e tratamentos.

Astrofísica e cosmologia

Simulações cosmológicas modelam a evolução do universo desde o Big Bang até hoje, rastreando bilhões de partículas virtuais representando matéria escura e galáxias. O projeto Illustris, por exemplo, simulou um cubo de universo com 106,5 megaparsecs de lado, gerando petabytes de dados sobre formação de estruturas cósmicas.

Análise de dados de telescópios espaciais como o James Webb também depende de algoritmos computacionais intensivos para processar imagens e identificar exoplanetas ou galáxias distantes.

Machine learning e inteligência artificial

O treinamento de modelos de deep learning, especialmente redes neurais convolucionais e transformers (como GPT), é um dos usos mais exigentes de computação científica atualmente. Treinar um modelo de linguagem de grande escala pode requerer:

- Semanas ou meses de processamento

- Centenas de GPUs trabalhando em paralelo

- Centenas de gigabytes de memória RAM

- Terabytes de dados de treinamento

Aplicações práticas incluem reconhecimento de imagem médica para diagnóstico de câncer, carros autônomos processando dados de sensores em tempo real, e sistemas de recomendação que analisam bilhões de interações de usuários.

Data science e big data

Análise de dados genômicos no sequenciamento do genoma humano gerou petabytes de informação. Bioinformatas usam clusters computacionais para identificar mutações, entender doenças genéticas e desenvolver medicina personalizada.

Na astronomia, o Square Kilometre Array (SKA) produzirá mais de um exabyte de dados anualmente, exigindo infraestrutura computacional sem precedentes para processar sinais de rádio do espaço profundo.

Pesquisas acadêmicas multidisciplinares

Universidades de ponta mantêm centros de computação científica que atendem departamentos de física, química, biologia, economia e ciências sociais. Economistas usam simulações de Monte Carlo para modelar mercados financeiros, enquanto cientistas sociais aplicam análise de redes para estudar propagação de informações em mídias sociais.

Por que hardware de alta performance é indispensável?

A natureza dos problemas científicos impõe demandas extraordinárias sobre o hardware:

Processamento paralelo massivo

Problemas científicos são naturalmente paralelizáveis. Uma simulação climática pode calcular o clima de diferentes regiões simultaneamente. CPUs modernas com 16, 32 ou mais núcleos permitem essa paralelização, mas GPUs levam isso a outro nível.

Uma GPU de computação científica como a NVIDIA RTX A6000 possui 10.752 núcleos CUDA, capazes de executar milhares de operações simultaneamente. Para deep learning e simulações, isso se traduz em acelerações de 10x a 100x comparado a CPUs convencionais.

Precisão e capacidade de cálculo

Cálculos científicos requerem precisão numérica excepcional. Hardware profissional oferece suporte robusto para aritmética de ponto flutuante de dupla precisão (64 bits), essencial para evitar erros de arredondamento que se acumulam em simulações longas.

Workstations científicas com processadores Intel Xeon ou AMD Threadripper Pro fornecem não apenas múltiplos núcleos, mas também tecnologias como AVX-512 que aceleram operações vetoriais críticas para álgebra linear.

Memória RAM abundante

Simulações complexas mantêm enormes matrizes e estruturas de dados na memória. Um modelo de elementos finitos de uma estrutura mecânica pode facilmente necessitar de 64 GB, 128 GB ou até 256 GB de RAM.

Workstations profissionais suportam memória ECC (Error-Correcting Code), que detecta e corrige erros de bit causados por radiação cósmica ou ruído elétrico, garantindo integridade dos cálculos em processamentos que duram dias ou semanas.

Armazenamento rápido e de alta capacidade

Simulações científicas geram terabytes de dados intermediários e resultados finais. SSDs NVMe com velocidades de leitura/gravação acima de 5 GB/s são essenciais para:

- Carregar grandes conjuntos de dados de entrada rapidamente

- Gravar resultados intermediários sem criar gargalos

- Realizar operações de I/O intensivas sem comprometer performance

Arrays RAID com múltiplos SSDs aumentam ainda mais a velocidade e fornecem redundância para proteger dados críticos de pesquisa.

Estabilidade e confiabilidade

Diferentemente de computadores domésticos, workstations científicas são projetadas para operação contínua 24/7. Componentes de nível empresarial, sistemas de refrigeração robustos e fontes de alimentação certificadas garantem estabilidade mesmo sob carga máxima prolongada.

Perder uma simulação de uma semana por causa de travamento ou superaquecimento não é aceitável em ambientes de pesquisa profissional.

Componentes críticos de uma workstation científica

Processador (CPU)

- Intel Xeon W ou AMD Threadripper Pro: Múltiplos núcleos (16-64), suporte a memória ECC, altas frequências de clock

- Cache grande: Caches L3 de 32 MB a 256 MB reduzem latência de acesso à memória

- Suporte a múltiplos sockets: Workstations dual-socket dobram o poder computacional

Unidades de processamento gráfico (GPUs)

- NVIDIA RTX série A ou Quadro: Otimizadas para computação científica e precisão numérica

- AMD Radeon Pro: Alternativa com excelente performance em aplicações específicas

- Memória VRAM abundante: 24 GB, 48 GB ou mais para modelos de IA complexos

- Suporte a múltiplas GPUs: Configurações com 2-4 GPUs para paralelização extrema

Memória RAM

- Capacidade: Mínimo 64 GB, idealmente 128 GB ou mais

- Tecnologia ECC: Essencial para confiabilidade em cálculos longos

- Alta frequência: DDR5 4800 MHz ou superior para menor latência

Armazenamento

- SSD NVMe primário: 1-2 TB para sistema operacional e aplicações

- Armazenamento secundário: Arrays RAID de SSDs ou HDDs de alta capacidade (10+ TB) para dados

- Backup: Soluções de backup automatizado para proteger anos de pesquisa

Refrigeração e fonte de alimentação

- Sistemas de refrigeração avançados: Liquid cooling ou dissipadores de alta performance

- Fontes de alimentação robustas: 1000W+ com certificação 80 Plus Gold/Platinum

- Gerenciamento térmico: Monitoramento inteligente para evitar throttling

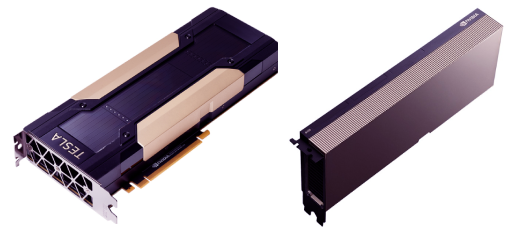

GPUs de supercomputação

Vale destacar uma curiosidade interessante sobre supercomputadores: muitos dos sistemas mais poderosos do mundo, incluindo clusters acadêmicos e centros de pesquisa de ponta, ainda utilizam GPUs que podem parecer “antigas” pelos padrões comerciais atuais, mas que continuam sendo workhorses extraordinárias da computação científica.

A NVIDIA Tesla V100, lançada em 2017 com arquitetura Volta, é um exemplo perfeito. Apesar de ter mais de 7 anos no mercado, ela ainda equipa inúmeros supercomputadores e clusters universitários ao redor do mundo. A razão é simples: esta GPU foi especificamente projetada para computação de alto desempenho (HPC) e deep learning, oferecendo recursos que GPUs gamers nunca tiveram:

- 5.120 núcleos CUDA otimizados para cálculos científicos

- 640 Tensor Cores dedicados a operações de inteligência artificial

- 32 GB de memória HBM2 com largura de banda de 900 GB/s

- Precisão dupla (FP64) com 7,8 teraflops – essencial para simulações científicas

- NVLink para comunicação de alta velocidade entre múltiplas GPUs

O que torna a V100 especial não é apenas o poder bruto, mas a estabilidade comprovada em operações 24/7 por anos, suporte a software científico maduro e documentação extensa. Muitos códigos de simulação e frameworks de machine learning foram otimizados especificamente para a arquitetura Volta, garantindo performance excepcional.

A lição aqui é valiosa: na computação científica, “mais recente” nem sempre significa “melhor para sua aplicação”. GPUs como a V100, ou mesmo suas sucessoras A100 e H100, são investimentos de longo prazo que continuam relevantes por uma década ou mais, diferentemente do ciclo de obsolescência rápido do hardware voltado para consumidores. Isso também explica por que workstations científicas bem projetadas, como as oferecidas pela Razor Computadores, mantêm valor e utilidade por muitos anos.

Vantagens das workstations Razor Computadores para Computação Científica

A Razor Computadores posiciona-se como parceira ideal para profissionais e instituições que demandam soluções de computação científica de alto nível, oferecendo vantagens competitivas significativas:

Configurações Personalizadas para Cada Aplicação

A Razor compreende que cada área científica tem requisitos únicos. Uma workstation para simulações CFD prioriza CPUs multi-core e RAM abundante, enquanto uma para deep learning foca em GPUs de última geração. A empresa oferece consultoria especializada para especificar a configuração ideal para o seu projeto específico.

Componentes de nível profissional

Todas as workstations Razor para computação científica utilizam:

- Processadores Intel Xeon W ou AMD Threadripper Pro

- GPUs profissionais NVIDIA RTX A-series ou Quadro

- Memória ECC de marcas premium (Kingston, Crucial, Corsair)

- SSDs NVMe empresariais com alta durabilidade (TBW)

- Fontes de alimentação certificadas e redundantes

Escalabilidade e upgrades

Workstations Razor são projetadas pensando no futuro. Slots de expansão abundantes permitem adicionar mais GPUs, memória ou armazenamento conforme suas necessidades crescem. Isso protege seu investimento e evita substituições prematuras.

Suporte técnico especializado

A equipe Razor oferece suporte técnico que entende as exigências da computação científica. Seja para otimização de BIOS para performance máxima, configuração de RAID, ou troubleshooting de compatibilidade de drivers científicos (CUDA, OpenCL, ROCm), você conta com expertise real.

Garantia e confiabilidade

Workstations Razor vêm com garantias extensas e opções de suporte on-site. Para ambientes de pesquisa onde downtime significa perda de prazos e recursos, esse nível de confiabilidade é inestimável.

Relação custo-benefício

Ao contrário de marcas internacionais que cobram prêmios por nome, a Razor oferece hardware de especificação equivalente ou superior a preços competitivos. Isso permite que laboratórios e centros de pesquisa maximizem seu orçamento, adquirindo mais poder computacional pelo mesmo investimento.

Integração com Software Científico

As workstations Razor são testadas para compatibilidade com principais ferramentas de computação científica:

- Simulação: ANSYS, COMSOL, OpenFOAM,

- Data Science: Python (NumPy, SciPy, Pandas), R, MATLAB

- Bioinformática, farmacologia e Life Sciences: GROMACS, NAMD, CHARMM

- Machine Learning: TensorFlow, PyTorch, CUDA Deep Neural Network library

- Visualização: ParaView, VisIt, VMD

Opções de configuração pré-otimizadas

Para facilitar a escolha, a Razor oferece linhas de produtos segmentadas:

- Linha Simulation: Focada em CPU multi-core, RAM abundante, armazenamento rápido

- Linha AI/ML: Prioriza GPUs múltiplas, VRAM máxima, NVLink para comunicação GPU-GPU

- Linha Data Analytics: Balanceada com processamento robusto e armazenamento massivo

- Linha Academic: Configurações otimizadas para orçamentos universitários sem comprometer performance essencial

Retorno sobre investimento em hardware de alta performance

Investir em workstations robustas pode parecer custoso inicialmente, mas o ROI é comprovado:

Redução de tempo de processamento

Uma simulação que leva 2 semanas em hardware convencional pode ser concluída em 2 dias em uma workstation otimizada. Isso significa:

- Mais iterações de design em menos tempo

- Publicações científicas mais rápidas

- Time-to-market reduzido para produtos baseados em simulação

Capacidade de abordar problemas mais complexos

Hardware limitado força simplificações e aproximações que podem comprometer resultados. Workstations poderosas permitem modelar sistemas mais realistas, com maior fidelidade, levando a descobertas e inovações impossíveis anteriormente.

Vantagem competitiva

Em campos competitivos como drug discovery ou desenvolvimento de materiais avançados, ser o primeiro a publicar ou patentear pode valer milhões. A capacidade de processar mais hipóteses mais rapidamente cria vantagem competitiva direta.

Conclusão: O futuro da Computação Científica

A computação científica continuará expandindo suas fronteiras, impulsionada por desafios cada vez mais complexos: mudanças climáticas, medicina personalizada, fusão nuclear, inteligência artificial geral. O hardware de alta performance não é mais um luxo, mas uma necessidade estratégica para qualquer organização séria sobre inovação baseada em ciência.

Workstations profissionais representam a fundação sobre a qual descobertas transformadoras são construídas. Com parceiros como a Razor Computadores, pesquisadores e instituições brasileiras têm acesso a tecnologia de ponta que nivela o campo de jogo com centros de excelência globais.

Se sua pesquisa depende de simulações complexas, análise massiva de dados, ou desenvolvimento de modelos de IA, chegou a hora de avaliar se seu hardware atual está sendo um facilitador ou um limitador do seu potencial. A diferença entre uma workstation convencional e uma solução otimizada pode ser a diferença entre resultados medianos e descobertas que mudam paradigmas.

Sobre a Razor Computadores

A Razor Computadores é especialista em soluções de hardware de alta performance para aplicações profissionais e científicas. Com experiência em configurar workstations para os requisitos mais exigentes, a Razor é a parceira ideal para pesquisadores, universidades e empresas que levam a computação científica a sério.

Entre em contato para uma consulta personalizada e descubra como as workstations Razor podem acelerar suas pesquisas e projetos mais ambiciosos.

Foque no seu trabalho, nós proporcionamos o hardware ideal para seus projetos!

Soluções customizadas de hardware para sua necessidade.

FALAR COM ESPECIALISTA