O que são memórias HBM (High Bandwidth Memory)

29/07/2025

Quando falamos em desempenho extremo para GPUs, data centers, IA ou aplicações científicas, não basta ter apenas uma boa placa de vídeo. A velocidade e o tipo da memória utilizada são determinantes. É aqui que entram as memórias HBM (High Bandwidth Memory), uma tecnologia que está revolucionando a forma como dados são acessados em aplicações de alta performance.

Neste blog, você vai entender o que é a memória HBM, como ela funciona, quais são suas vantagens e onde ela está sendo aplicada atualmente. Vamos mostrar por que esse tipo de memória é tão relevante para quem busca performance em ambientes gráficos e computacionais exigentes.

O que é memória HBM?

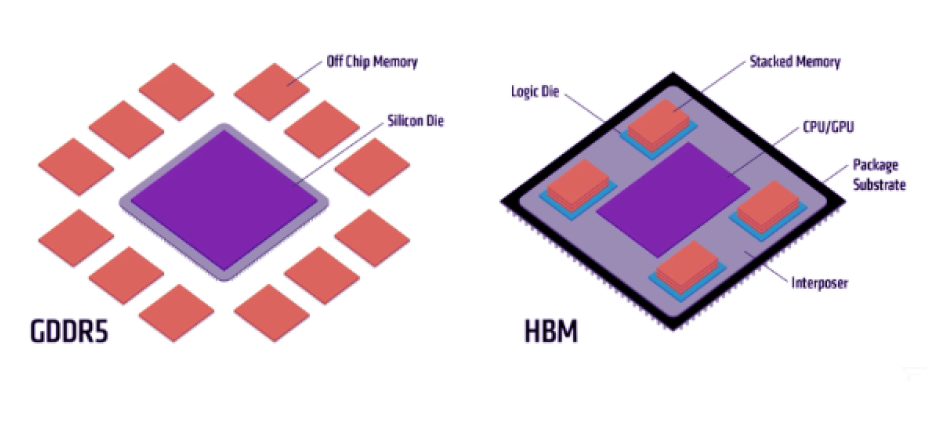

HBM (High Bandwidth Memory) é um tipo de memória RAM de alto desempenho que oferece largura de banda superior à das memórias GDDR tradicionais, como GDDR6 ou GDDR6X, usadas em grande parte das placas de vídeo atuais. Ela foi desenvolvida pela AMD em parceria com a SK Hynix e apresentada ao mercado em 2015.

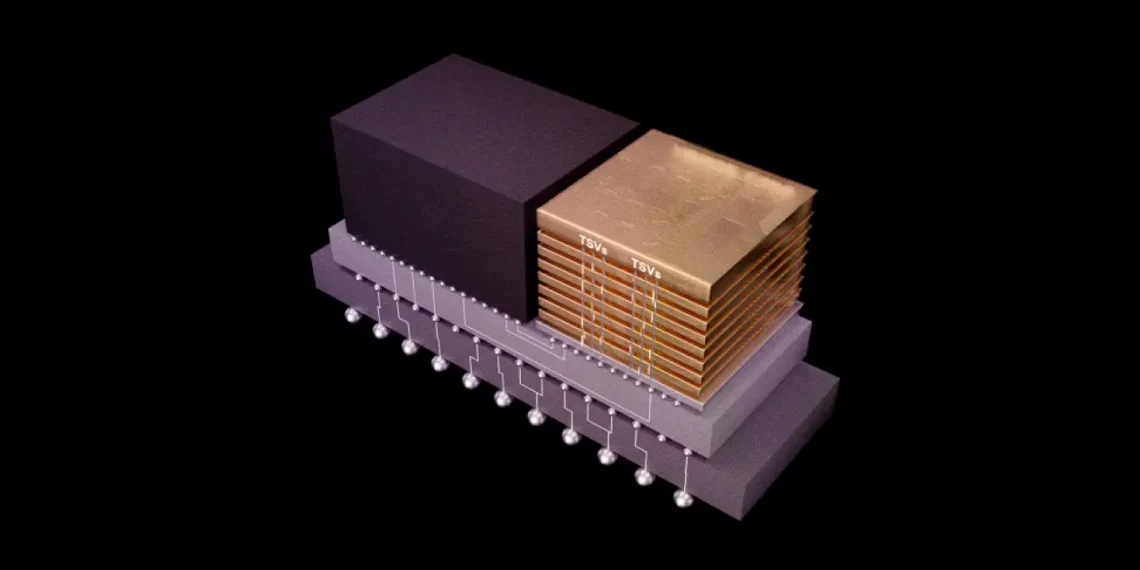

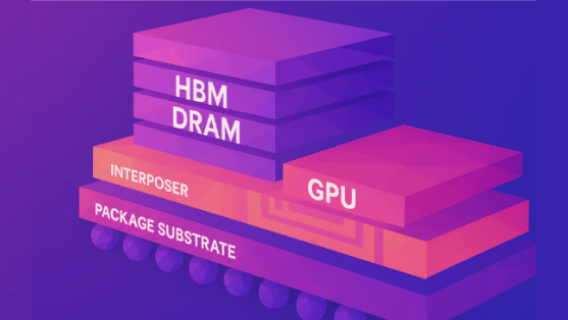

Ao contrário das memórias GDDR, que ficam espalhadas em volta da GPU em módulos externos, as HBM são empilhadas verticalmente (em 3D) sobre o próprio chip gráfico ou próximas a ele, utilizando interconexões chamadas TSVs (Through-Silicon Vias). Como resultado, essa estrutura reduz drasticamente a distância que os dados precisam percorrer, resultando em maior velocidade, menor latência e melhor eficiência energética.

Como a HBM funciona?

A arquitetura da memória HBM é baseada em pilhas de chips DRAM empilhadas verticalmente, com até 8 dies (camadas) em uma única estrutura. Nesse meio tempo, essas pilhas, ficam posicionadas em um interposer de silício, uma base intermediária que conecta a GPU e a memória com um caminho de comunicação muito mais curto e eficiente.

Dessa forma, a arquitetura da memória HBM empilha os chips e os integra diretamente à GPU, o que amplia a largura de banda, reduz o consumo de energia e economiza espaço na placa.

Atualmente, existem várias gerações de HBM, e cada uma delas aprimora largura de banda, densidade e eficiência:

HBM1 – O primeiro passo rumo à largura de banda extrema

Lançada em 2013, a HBM1 marcou uma ruptura com as memórias GDDR tradicionais, ao oferecer uma arquitetura empilhada verticalmente (3D), interligada através de TSVs (vias de silício) e interposers de silício.

Cada stack de HBM1 possui largura de banda de até 128 GB/s, com um total de quatro camadas de DRAM empilhadas. Embora não tenha sido amplamente adotada no mercado, ela representou a base para inovações futuras, sendo utilizada, por exemplo, nas placas AMD Radeon Fury X, uma das pioneiras no uso comercial da tecnologia.

HBM2 – Mais velocidade, mais densidade, mais eficiência

A segunda geração, HBM2, chegou ao mercado em 2016 com melhorias significativas em todos os aspectos. Cada stack passou a oferecer até 256 GB/s de largura de banda, com até 8 camadas de memória DRAM empilhadas. Assim, essa geração aumentou também a capacidade por stack para até 8 GB, sendo ideal para workloads mais pesados.

Ela se tornou padrão em placas de vídeo profissionais da AMD e Nvidia voltadas para data centers e aplicações científicas, como as GPUs Nvidia Tesla e Radeon Instinct. Além disso, trouxe melhor eficiência energética em relação às GDDR5 e GDDR6, especialmente em cargas paralelas.

HBM2E – Potência elevada para IA e HPC

A HBM2E é uma versão refinada da HBM2, projetada para atender às demandas crescentes de inteligência artificial, machine learning, deep learning e aplicações em computação de alto desempenho (HPC).

Ela alcança uma largura de banda impressionante de até 460 GB/s por stack, e cada pilha pode conter até 16 GB de memória, dobrando a densidade da geração anterior. A Nvidia utiliza a HBM2E em aceleradoras de IA e GPUs como a A100 para rodar cargas massivas com máxima largura de banda e mínima latência.

HBM3 – A revolução para data centers e IA generativa

Anunciada em 2022 e já presente em chips de ponta como as GPUs Nvidia H100 e AMD MI300X, a HBM3 é a mais poderosa geração até o momento. Ela oferece até 819 GB/s por stack, o que, em sistemas com múltiplas pilhas, pode ultrapassar 1 TB/s de largura de banda total.

Além disso, assim como as gerações anteriores, a HBM3 também traz melhorias em consumo energético e controle térmico. Cada stack pode atingir até 24 GB de capacidade, permitindo configurações com mais de 100 GB de memória total em sistemas de inferência de IA.

Engenheiros projetaram a HBM3 para cargas de trabalho extremamente paralelas, como modelos de linguagem de larga escala (LLMs), treinamento de IA generativa e simulações em larga escala, onde o throughput de memória representa um gargalo crítico.

Principais vantagens da memória HBM

As memórias HBM oferecem uma série de benefícios em relação às tecnologias convencionais:

Altíssima largura de banda

A principal vantagem da HBM é a largura de banda massiva. Enquanto uma GDDR6 oferece cerca de 448 GB/s de largura de banda total, uma solução com HBM2E ou HBM3 pode ultrapassar 1 TB/s. Isso garante desempenho superior em cargas de trabalho intensas.

Eficiência energética

Mesmo entregando mais velocidade, a HBM consome menos energia por bit transferido. Isso ocorre graças ao seu design compacto e interconexões curtas, que reduzem o esforço elétrico na comunicação.

Menor espaço físico

Por ser empilhada verticalmente, a HBM ocupa menos espaço na placa. Isso permite a criação de placas de vídeo mais compactas ou com espaço extra para outros componentes, como núcleos adicionais ou sistemas de resfriamento mais robustos.

Latência reduzida

A proximidade da HBM com o chip gráfico reduz a latência, o que resulta em respostas mais rápidas e maior fluidez em tarefas exigentes.

Onde a memória HBM é usada?

O alto custo e a complexidade de fabricação ainda impedem que fabricantes usem HBM amplamente em GPUs voltadas para consumidores domésticos. No entanto, ela já é essencial em segmentos profissionais:

Placas de vídeo para workstations e data centers

Modelos como a NVIDIA A100, H100 e as GPUs AMD Instinct MI250 utilizam memórias HBM2 ou HBM3 para acelerar cargas de IA, machine learning, renderização 3D, simulações científicas e edição de vídeo em altíssima resolução.

Computação de alto desempenho (HPC)

Supercomputadores e centros de pesquisa utilizam GPUs com HBM para simulações físicas, análise de dados em larga escala e modelagem climática.

Inteligência Artificial

As redes neurais profundas, usadas em IA generativa e modelos de linguagem, exigem uma troca massiva de dados em tempo real. A HBM permite que essas operações ocorram com mais rapidez e menos gargalos.

Gaming (em menor escala)

Placas como a AMD Radeon R9 Fury X e Vega 64 já utilizaram HBM, mas o alto custo impediu sua adoção em larga escala. Hoje, GPUs gamers continuam usando GDDR, enquanto a HBM se mantém no segmento profissional.

Vale a pena investir em uma GPU com HBM?

Se você trabalha com IA, simulação, renderização 3D pesada ou projetos científicos, sim. A HBM vai garantir que seu sistema flua sem gargalos de memória, mesmo em cargas de trabalho intensas. No entanto, essas placas com HBM costumam estar disponíveis apenas em workstations e servidores profissionais, como os oferecidos pela Razor.

Aqui, desenvolvemos máquinas sob medida para o seu fluxo de trabalho, com suporte para GPUs de última geração com memória HBM. Se o seu projeto exige o máximo de performance, nossas workstations entregam exatamente isso, desde o primeiro dia.

Conclusão

A memória HBM representa um avanço fundamental na arquitetura de placas gráficas e sistemas de alta performance. Ela está mudando os padrões de processamento de grandes volumes de dados, oferecendo mais velocidade, menor consumo e latência reduzida.

Para quem busca performance profissional, seja em inteligência artificial, ciência de dados ou edição de vídeo de altíssima resolução, as GPUs com HBM e uma workstation bem configurada são o combo ideal.

Então, quer saber se o seu projeto precisa de HBM? Fale com um especialista da Razor e descubra a solução ideal para seu desafio técnico.

Foque no seu trabalho, nós proporcionamos o hardware ideal para seus projetos!

Soluções customizadas de hardware para sua necessidade.

FALAR COM ESPECIALISTA