Como Funciona as LLMS: A Base da IA

22/07/2024

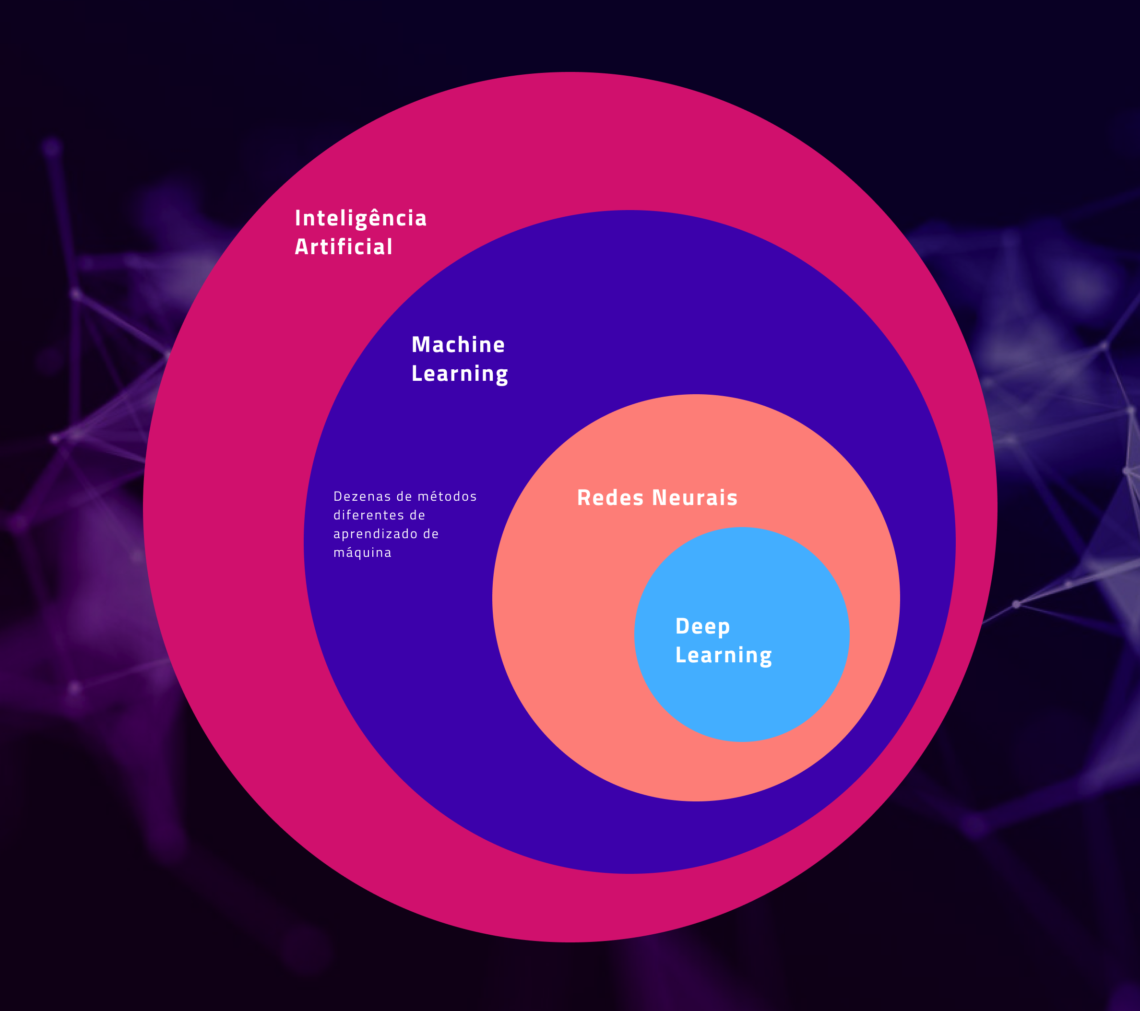

Nos últimos anos, as tecnologias de Deep Learning, Machine Learning e Inteligência Artificial (IA) têm avançado significativamente, transformando diversos setores. Contudo, destacam-se os Modelos de Linguagem de Grande Escala (Large Language Models – LLMs), como o ChatGPT, que se tornaram fundamentais para diversas aplicações.

LLMs são sistemas de IA projetados para compreender e gerar texto de maneira semelhante aos humanos. Ou seja, eles são capazes de realizar tarefas complexas, desde a criação de conteúdo até o suporte técnico automatizado, graças à combinação de técnicas avançadas de Deep Learning e Machine Learning.

O que são LLMs e como funcionam

Os LLMs, como o ChatGPT, são construídos usando redes neurais profundas – deep neural networks -, que são estruturas complexas de algoritmos inspiradas na forma como o cérebro humano processa informações. Em resumo, estas redes são compostas por camadas de neurônios artificiais, onde cada camada processa informações de maneira progressiva, refinando e aprimorando a saída a cada nova etapa.

Redes Neurais: O Coração dos LLMs

As redes neurais são a base dos LLMs. Portanto, funcionam de maneira semelhante ao cérebro humano, onde cada neurônio artificial recebe informações, realiza cálculos e passa os resultados para os neurônios da próxima camada. Este processo é repetido milhares ou até milhões de vezes durante o treinamento do modelo, permitindo que ele aprenda padrões complexos e sutilezas da linguagem. Posto de forma simples, é similar a dizer que o programa aprende por tentativa e erro e reconhecimento de padrões.

Uma analogia útil é imaginar uma rede neural como uma equipe de especialistas. Cada especialista (neurônio) foca em uma parte específica do problema passando a equipe seguinte no processo suas descobertas. Ou seja, suas contribuições são combinadas para produzir uma solução abrangente e de melhor performance. Dessa forma, quanto mais complexa a tarefa, mais especialistas são necessários, e mais refinado se torna o resultado final.

A Dinâmica por Trás dos LLMs: Deep Learning e Machine Learning

Deep Learning

Deep Learning é uma subcategoria do Machine Learning que utiliza redes neurais com muitas camadas (daí o termo “profundas”). Assim, esta profundidade permite que os modelos de Deep Learning capturem e aprendam características muito complexas dos dados. Em resumo, no caso dos LLMs, eles aprendem nuances da linguagem humana, incluindo gramática, contexto e semântica.

Machine Learning

Machine Learning, por sua vez, é o campo da IA focado em permitir que as máquinas aprendam com dados. Mas, em vez de serem explicitamente programadas para realizar uma tarefa, as máquinas usam algoritmos de aprendizado para melhorar seu desempenho com base em dados de treinamento. Para LLMs, isso significa treinar o modelo com grandes quantidades de texto para que ele possa prever e gerar texto de forma precisa.

Evolução das Tecnologias de IA

As tecnologias de IA evoluíram drasticamente nas últimas décadas. Nos anos 1950, as primeiras redes neurais artificiais foram desenvolvidas, mas enfrentaram limitações devido à falta de poder computacional e dados suficientes. Com o advento de GPUs (as placas gráficas) poderosas e grandes quantidades de dados disponíveis na era da internet, o campo de Deep Learning floresceu.

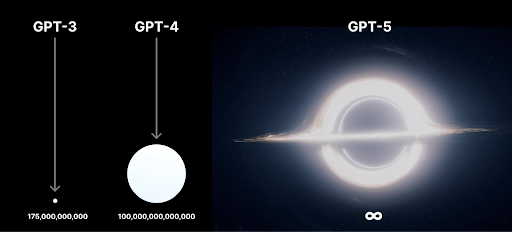

Dessa forma, nos anos 2010, vimos o surgimento dos primeiros LLMs, que rapidamente se tornaram mais sofisticados com o aumento da capacidade de processamento e técnicas avançadas de treinamento. Atualmente, modelos como o GPT-4 são capazes de processar e gerar texto em um nível quase humano.

Números e Comparações

Treinar um LLM como o GPT-4 envolve processar imensas quantidades de dados e requer um poder computacional significativo. Por exemplo, treinar o GPT-4 pode envolver até +100 teraflops por segundo de computação contínua por semanas ou meses. Para efeitos comparativos, uma única CPU Intel de última geração alcança até 0.5 teraflops/s em algumas condições.

Para dar uma ideia do volume de dados, imagine que 1 TB de texto equivale a aproximadamente 1 milhão de livros de 500 páginas cada. Isso demonstra a escala de informações que esses modelos devem processar para alcançar seu nível de desempenho.

Exemplos Práticos de Uso dos LLMs

Os LLMs têm uma ampla gama de aplicações práticas. Alguns exemplos incluem:

- Assistentes Virtuais: Ferramentas como Siri e Alexa usam LLMs para entender e responder a comandos de voz.

- Criação de Conteúdo: Ferramentas como ChatGPT podem gerar artigos, histórias e scripts, auxiliando escritores e jornalistas.

- Suporte Técnico Automatizado: Empresas utilizam LLMs para oferecer suporte ao cliente 24/7, respondendo perguntas comuns e resolvendo problemas básicos.

- Tradução de Idiomas: LLMs como o Google Translate oferecem traduções precisas e contextualmente adequadas entre vários idiomas.

Customização de LLMs

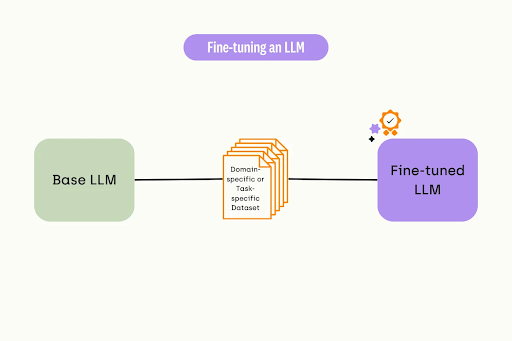

Uma das grandes vantagens dos LLMs é sua capacidade de serem customizados para diferentes usos. Dessa forma empresas podem ajustar esses modelos para atender a necessidades específicas, como atendimento ao cliente, análise de sentimentos em redes sociais ou automação de processos administrativos.

Atualmente a customização envolve treinamento adicional com dados específicos do domínio, o que melhora a precisão e relevância das respostas do modelo para aquele contexto particular. Portanto, esse afinamento – ou fine tuning – do modelo como a um carro esporte customizado e cuidadosamente ajustado para ter máxima performance num determinado tipo de pista escolhido.

Considerações Finais

Os Modelos de Linguagem de Grande Escala, como o ChatGPT, representam um avanço significativo no campo da Inteligência Artificial. Com o poder das redes neurais profundas, esses modelos estão revolucionando a forma como interagimos com a tecnologia e automatizamos tarefas complexas.

Então se você deseja explorar mais sobre IA ou precisa de uma solução de hardware customizada para treinar e utilizar aplicações de IA, nossa equipe de especialistas da Razor está à disposição para ajudar. Fale conosco para montar uma workstation de alta performance que atenda às suas necessidades para inteligência artificial específicas.

Para continuar acompanhando nossas publicações e novidades, siga-nos em nossas redes sociais e assine nosso blog. Se você precisa de hardware de alta performance para suas aplicações de IA, entre em contato com nosso time de especialistas para criar a solução perfeita para você.

Foque no seu trabalho, nós proporcionamos o hardware ideal para seus projetos!

Soluções customizadas de hardware para sua necessidade.

FALAR COM ESPECIALISTA